Pipeline() işlevi Transformer kütüphanesinin ayrılmaz bir parçasıdır. Bir çıkarım görevi, modeller, tokenizasyon mekanizması vb. tanımlayabileceğimiz birkaç girdi alır. Pipeline() işlevi büyük ölçüde bir veya daha fazla metin üzerinde NLP görevlerini gerçekleştirmek için kullanılır. İnsan tarafından okunabilir çıktı ve maksimum doğrulukla doğru tahmin oluşturmak için modele dayalı olarak girdi üzerinde ön işleme ve son işleme gerçekleştirir.

Bu makale aşağıdaki hususları kapsamaktadır:

- Hugging Face Veri Kümeleri Kütüphanesi Nedir?

- Hugging Face'te Veri Kümesine Boru Hatları Nasıl Uygulanır?

Hugging Face Veri Kümesi Kütüphanesi Nedir?

Hugging Face veri kümesi kitaplığı, çeşitli genel veri kümelerini içeren ve bunları indirmenin kolay bir yolunu sağlayan bir API'dir. Bu kütüphane “” kullanılarak uygulamaya aktarılabilir ve kurulabilir. pip ' emretmek. Hugging Face kitaplığının veri kümelerini indirmeye ve kurmaya yönelik pratik bir gösteri için burayı ziyaret edin Google Colab bağlantısı. Birden fazla veri kümesini şuradan indirebilirsiniz: Sarılma Yüz Veri Kümesi Merkezi.

Pipeline() işlevinin işleyişi hakkında daha fazla bilgiyi şu makaleye bakarak öğrenebilirsiniz: ' Transformers'ta Pipeline() Fonksiyonu Nasıl Kullanılır? ”.

Hugging Face'te Veri Kümesine Boru Hatları Nasıl Uygulanır?

Hugging Face, tek satırlık kod kullanılarak kolayca kurulabilen birçok farklı genel veri kümesi sağlar. Bu makalede, bu veri kümelerine işlem hatlarını uygulamanın pratik bir gösterimini göreceğiz. Veri kümesinde işlem hatlarının uygulanmasının iki yolu vardır.

Yöntem 1: Yineleme Yöntemini Kullanma

Pipeline() işlevi bir veri kümesi ve model üzerinde de yinelenebilir. Bu amaçla aşağıda belirtilen adımları izleyin:

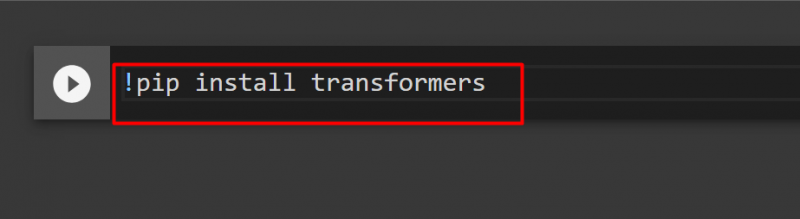

Adım 1: Transformer Library'yi yükleyin

Transformer kütüphanesini kurmak için aşağıdaki komutu girin:

!pip transformatörleri kurun

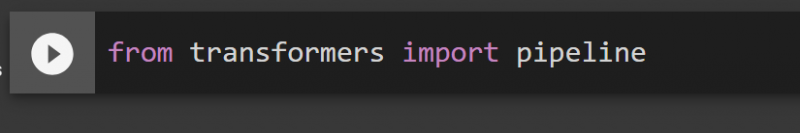

Adım 2: İşlem Hatlarını İçe Aktarın

Pipeline'ı Transformer kütüphanesinden import edebiliriz. Bu amaçla aşağıdaki komutu sağlayın:

trafo ithalat boru hattından

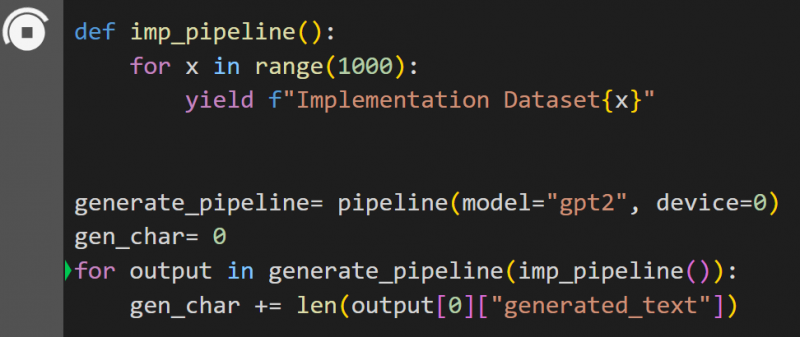

3. Adım: Pipeline'ı Uygulayın

Burada “pipeline()” fonksiyonu “model üzerinde” uygulandı. gpt2 ”. Modelleri şuradan indirebilirsiniz: Sarılma Yüzü Model Merkezi:

def imp_pipeline():(1000) aralığındaki x için:

verim f'Uygulama Veri Kümesi{x}'

created_pipeline= boru hattı(model = 'gpt2', cihaz = 0)

gen_karakter= 0

created_pipeline(imp_pipeline()) içindeki çıktı için:

gen_char += len(çıkış[0]['oluşturulan_metin'])

Bu kodda “ created_pipeline ”, “ modeline sahip boru hattı() fonksiyonunu içeren bir değişkendir gpt2 ”. “ ile çağrıldığında imp_pipeline() ” fonksiyonu, 1000 olarak belirtilen aralıkla artırılan verileri otomatik olarak tanır:

Bunun eğitilmesi biraz zaman alacaktır. Bağlantı Google Şirketi da verilmektedir.

Yöntem 2: Veri Kümeleri Kitaplığını Kullanma

Bu yöntemde, 'datasets' kütüphanesini kullanarak işlem hattının uygulanmasını göstereceğiz:

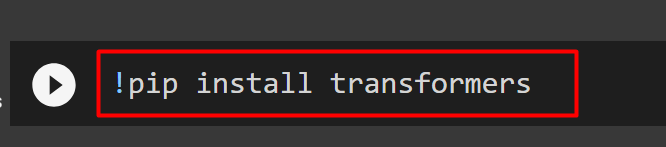

Adım 1: Transformatörü Kurun

Transformer kütüphanesini kurmak için aşağıdaki komutu girin:

!pip transformatörleri kurun

2. Adım: Veri Kümesi Kitaplığını Kurun

Olarak “ veri kümeleri ” kütüphanesi tüm public veri setlerini içeriyor, aşağıdaki komutu kullanarak kurulumunu yapabiliriz. “Kurarak veri kümeleri ” kütüphanesine adını vererek herhangi bir veri kümesini doğrudan içe aktarabiliriz:

!pip kurulum veri kümeleri

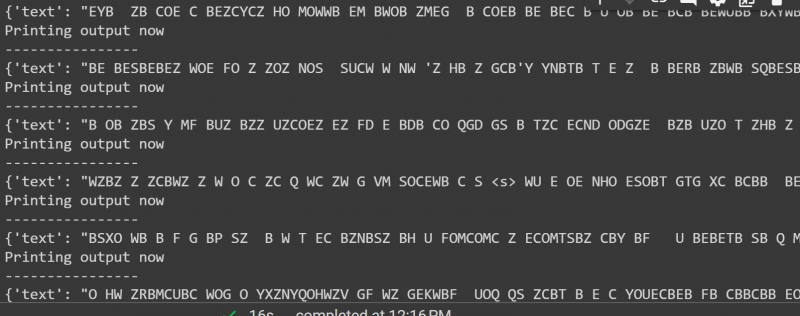

Adım 3: Veri Kümesi Ardışık Düzeni

Veri kümesinde işlem hattı oluşturmak için aşağıdaki kodu kullanın. KeyDataset, yalnızca kullanıcının ilgisini çeken değerlerin çıktısını veren bir özelliktir:

transformatörler.pipelines.pt_utils'den KeyDataset'i içe aktarıntrafo ithalat boru hattından

veri kümelerinden load_dataset'i içe aktar

gen_pipeline = boru hattı(model = 'hf-internal-testing/tiny-random-wav2vec2', cihaz=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')gen_pipeline(KeyDataset(loaddataset, 'audio')): çıktı için

print('Çıktı şimdi yazdırılıyor')

Yazdır ('----------------')

yazdır(çıktı)

Yukarıdaki kodun çıktısı aşağıda verilmiştir:

Bu rehberden hepsi bu. Bağlantı Google Şirketi bu yazıda da bahsediliyor

Çözüm

Veri kümesine işlem hatları uygulamak için, bir boru hattı() işlevini kullanarak bir veri kümesi üzerinde yineleme yapabiliriz veya ' veri kümeleri ' kütüphane. Hugging Face, kullanıcılarına hem veri setleri hem de ihtiyaçlara göre kullanılabilecek modeller için GitHub repository bağlantısını sağlıyor. Bu makale, Transformers'taki bir veri kümesine ardışık düzenleri uygulamaya yönelik kapsamlı bir kılavuz sağladı.