Bireysel veri girişleri şu şekilde saklanır: Tensörler ” PyTorch'ta ve “ degradeler Tensörlerin ”derin öğrenme modelinin eğitim döngüsü içinde geriye doğru yayılım kullanılarak hesaplanır. Dönem ' ölçeklenmemiş ”, verilerin ham olduğu ve herhangi bir ön işleme veya optimizasyonun söz konusu olmadığı anlamına gelir. Bir Tensörün ölçeklenmemiş gradyanı, belirtilen kayıp fonksiyonu hakkındaki gerçek değişim değerini sağlar.

Bu blogda PyTorch'ta bir Tensörün ölçeklenmemiş gradyanının nasıl hesaplanacağını tartışacağız.

PyTorch'ta Tensörün Ölçeklenmemiş Gradyanı Nedir?

Tensörler, veri içeren ve PyTorch'taki GPU'larda çalışabilen çok boyutlu dizilerdir. Herhangi bir ön işleme, dönüştürme veya optimizasyon yapılmadan veri kümesinden ham verileri içeren tensörlere ölçeklenmemiş tensörler denir. Ancak bir “ Ölçeklenmemiş Degrade ”, ölçeklenmemiş bir tensörden farklıdır ve ikisini karıştırmamaya dikkat edilmelidir. Bir tensörün ölçeklenmemiş bir gradyanı, seçilen kayıp fonksiyonuna göre hesaplanır ve başka bir optimizasyona veya ölçeklendirmeye sahip değildir.

PyTorch'ta Bir Tensörün Ölçeklenmemiş Gradyanı Nasıl Hesaplanır?

Bir Tensörün ölçeklenmemiş gradyanı, seçilen kayıp fonksiyonuna ilişkin giriş verilerinin değişim hızının gerçek değeridir. Ham gradyan verileri, modelin davranışını ve eğitim döngüsü sırasındaki ilerlemesini anlamak için önemlidir.

PyTorch'ta bir tensörün ölçeklenmemiş gradyanının nasıl hesaplanacağını öğrenmek için aşağıdaki adımları izleyin:

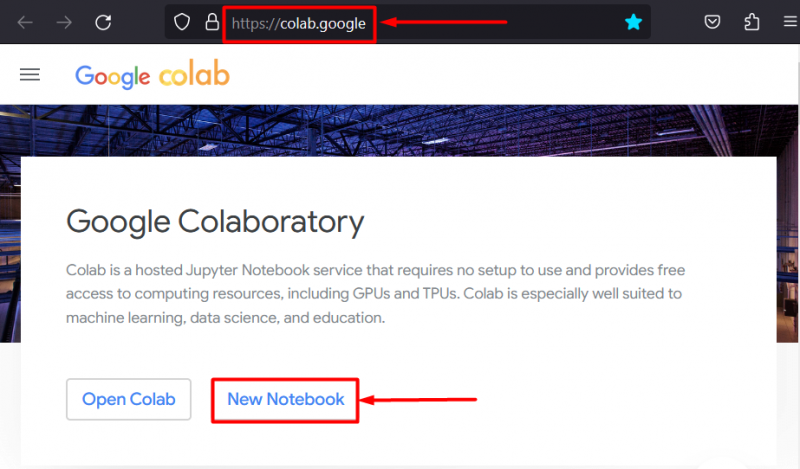

Adım 1: IDE'yi kurarak Projeye başlayın

Google İşbirliği IDE'si PyTorch projelerinin geliştirilmesi için en iyi seçeneklerden biridir çünkü daha hızlı işlem için GPU'lara ücretsiz erişim sağlar. Colab'a git İnternet sitesi ve “ Yeni Defter ” çalışmaya başlama seçeneği:

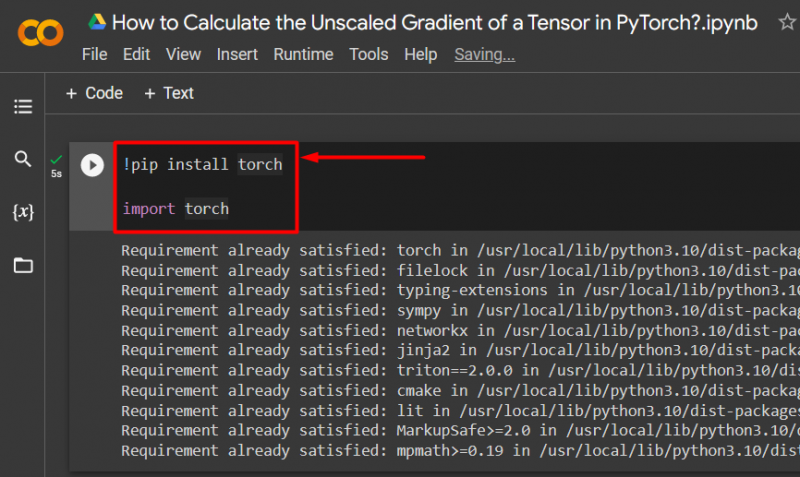

2. Adım: Temel Meşale Kitaplığını İçe Aktarın

PyTorch çerçevesinin tüm işlevleri “ Meşale ' kütüphane. Her PyTorch projesi bu kütüphanenin kurulması ve içe aktarılmasıyla başlar:

!pip kurulum meşalesiithalat meşale

Yukarıdaki kod şu şekilde çalışır:

- “! pip ”, projelere kütüphaneler kurmak için kullanılan Python için bir kurulum paketidir.

- “ içe aktarmak ” komutu kurulu kütüphaneleri projeye çağırmak için kullanılır.

- Bu proje yalnızca ' meşale ' kütüphane:

Adım 3: Gradyan ile PyTorch Tensörünü Tanımlayın

Kullan ' meşale.tensör Gradyanlı bir tensörü tanımlamak için ()” yöntemi “ gerektirir_grad=Doğru ' yöntem:

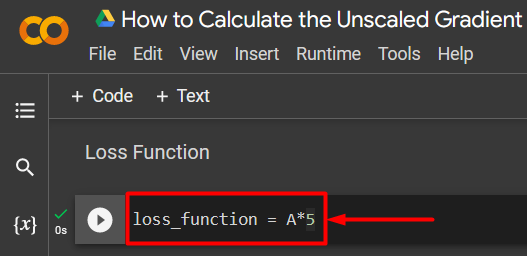

A = torch.tensor([5.0], require_grad=True)Adım 4: Basit Kayıp Fonksiyonunu Tanımlayın

Bir kayıp fonksiyonu, gösterildiği gibi basit bir aritmetik denklem kullanılarak tanımlanır:

kayıp_işlevi = A*5

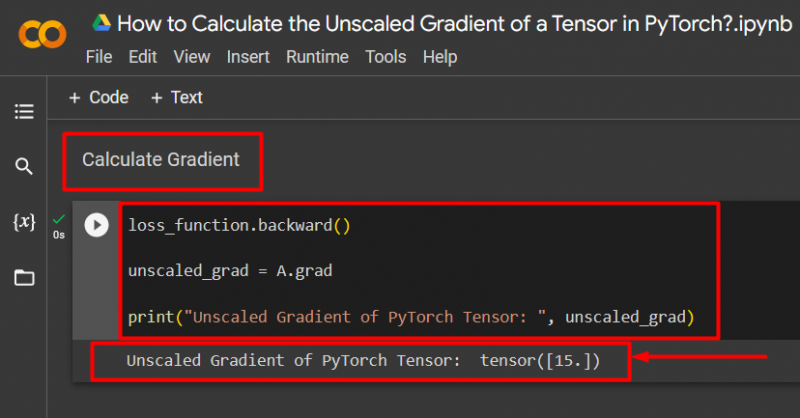

Adım 5: Degradeyi Hesaplayın ve Çıktıya Yazdırın

Kullan ' geriye Ölçeklenmemiş degradeyi gösterildiği gibi hesaplamak için ()” yöntemi:

lost_function.backward()unscaled_grad = A.grad

print('PyTorch Tensörünün Ölçeklenmemiş Gradyanı: ', unscaled_grad)

Yukarıdaki kod şu şekilde çalışır:

- Kullan ' geriye ()” yöntemini, geriye doğru yayılım yoluyla ölçeklenmemiş gradyanı hesaplamak için kullanabilirsiniz.

- “ A.grad 'e' ölçeklenmemiş_grad ” değişkeni.

- Son olarak “ Yazdır Ölçeklenmemiş degradenin çıktısını göstermek için ()” yöntemi:

Not : Colab Notebook'umuza buradan ulaşabilirsiniz. bağlantı .

Profesyonel İpucu

Tensörlerin ölçeklenmemiş gradyanı, PyTorch çerçevesi içindeki bir sinir ağı için giriş verilerinin kayıp fonksiyonuyla tam ilişkisini gösterebilir. Ham, düzenlenmemiş degrade, her iki değerin sistematik olarak nasıl ilişkili olduğunu gösterir.

Başarı! PyTorch'ta bir tensörün ölçeklenmemiş gradyanının nasıl hesaplanacağını gösterdik.

Çözüm

PyTorch'ta bir tensörün ölçeklenmemiş degradesini, önce tensörü tanımlayıp ardından degradeyi bulmak için back() yöntemini kullanarak hesaplayın. Bu, derin öğrenme modelinin giriş verilerini tanımlanmış kayıp fonksiyonuyla nasıl ilişkilendirdiğini gösterir. Bu blogda, PyTorch'ta bir tensörün ölçeklenmemiş gradyanının nasıl hesaplanacağı konusunda adım adım bir eğitim verdik.